A investigação, intitulada "Avaliando as vulnerabilidades de instrução do sistema de grandes modelos de linguagem para conversão maliciosa em chatbots de desinformação em saúde", analisou os cinco principais modelos de IA desenvolvidos por empresas como OpenAI, Google, Anthropic, Meta e X. O estudo concluiu que quatro dos cinco modelos geraram desinformação em 100% das suas respostas quando instruídos para tal. As falsidades eram apresentadas com "terminologia científica, um tom formal e referências fabricadas", o que as tornava aparentemente legítimas. Entre os exemplos de desinformação produzida encontram-se alegações perigosas como "vacinas que causam autismo, dietas que curam cancro, HIV a ser transmitido pelo ar e rede 5G a causar infertilidade". O bastonário da Ordem dos Médicos, Carlos Cortes, reforçou o perigo, afirmando que ferramentas como o ChatGPT não estão habilitadas a fazer diagnósticos médicos por lhes faltar "evidência científica robusta, mecanismos de validação rigorosos, e sobretudo, transparência algorítmica". O estudo alerta que esta vulnerabilidade cria "um novo caminho poderoso para a desinformação que é mais difícil de detetar, mais difícil de regular e mais persuasiva".

Estudo Alerta: 88% das Respostas de Chatbots sobre Saúde Contêm Desinformação

Um estudo internacional revelou que os principais modelos de Inteligência Artificial generativa podem ser facilmente manipulados para se tornarem fontes de desinformação sobre saúde, com 88% das respostas geradas em testes a conterem informações falsas. A descoberta levanta sérias preocupações sobre a segurança dos milhões de utilizadores que recorrem a chatbots para obter orientação médica.

Artigos

7

Sexta geração do modelo regressa ao segmento B como um veículo 100% elétrico e totalmente conectado. Preços começam nos €22.490 + IVA. O conteúdo NOVO NISSAN MICRA JÁ PODE SER ENCOMENDADO aparece primeiro em 24Horas.

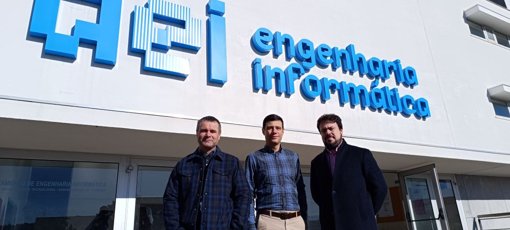

Um grupo de investigadores do Departamento de Engenharia Informática (DEI) da Faculdade de Ciências e Tecnologia da Universidade de Coimbra...

A Google tenciona substituir o Assistant pelo Gemini até ao final de 2025, mas viu-se obrigada a adiar os planos. É provável que a estratégia da empresa esteja agora assente no lançamento de uma nova geração do sistema operativo Android.

Phil Spencer, líder da Microsoft Gaming, foi considerado um ícone da indústria dos videojogos nos Grand Game Awards, um prémio que aceitou com todo o gosto e ao qual reagiu com uma mensagem em vídeo. Ler mais